Loi SB 1047 : Quand la Californie tente d’encadrer les modèles d’IA avancés

La loi SB 1047 visait à réglementer les modèles d’IA avancés. Cependant, le gouverneur Gavin Newsom a récemment opposé son veto. Décryptage.

Par Magali Mezerette – Le 17 octobre 2024

Avec l’essor rapide de l’intelligence artificielle, les gouvernements du monde entier cherchent à réguler cette technologie pour prévenir ses dérives potentielles. La Californie, épicentre de l’innovation technologique, a tenté d’apporter une réponse via la loi SB 1047. Cette loi, adoptée par l’Assemblée en août 2024, visait à réglementer les modèles d’IA avancés. Cependant, le gouverneur Gavin Newsom a récemment opposé son veto, mettant ainsi en pause une régulation clé dans le domaine de l’IA aux États-Unis.

Cet article fait suite au webinaire organisé par Unow et Tomorrow Theory qui a eu lieu en septembre 2024. Pour voir le replay :

Qu’est-ce que la loi SB 1047 ?

La loi SB 1047, introduite en février 2024, visait à encadrer les systèmes d’IA à haute capacité, définis comme des modèles ayant un coût de développement supérieur à 100 millions de dollars et nécessitant une énorme puissance de calcul (supérieure à 10^25 opérations). La loi se concentrait spécifiquement sur les modèles d’IA dits « avancés », capables de traiter d’énormes quantités de données et d’effectuer des opérations complexes. Elle visait à combler le vide réglementaire pour des technologies dont l’impact potentiel sur la société pourrait être immense.

Trois axes principaux étaient proposés dans la loi :

1. Tests de sécurité obligatoires : Les entreprises devaient soumettre leurs systèmes d’IA à des simulations de cyberattaques et à des audits de sécurité réguliers pour détecter et corriger les vulnérabilités.

2. Kill switch : La loi exigeait l’implémentation d’un mécanisme d’arrêt d’urgence, permettant de désactiver un système d’IA en cas de dérive ou de dysfonctionnement.

3. Protection des lanceurs d’alerte : Les personnes signalant des biais ou des dysfonctionnements dans les systèmes d’IA devaient être protégées pour s’assurer que les alertes soient prises en compte et que les systèmes soient corrigés en conséquence.

Le veto de Gavin Newsom

Malgré l’adoption de la loi à l’Assemblée, le gouverneur Gavin Newsom a opposé son veto en octobre 2024, soulignant que la loi, bien qu’ambitieuse, n’était pas adaptée aux risques actuels. Dans sa déclaration, Newsom a mis en avant plusieurs points clés :

- Critique des critères basés sur les coûts : La loi fixait des seuils basés principalement sur le coût de développement (100 millions de dollars) et la puissance de calcul des modèles. Newsom a estimé que ces critères étaient trop restrictifs et qu’ils offraient une fausse impression de sécurité. Selon lui, même des modèles moins coûteux ou moins puissants pourraient représenter des risques importants.

- Manque de flexibilité : La loi ne prenait pas en compte les IA de petite échelle qui, bien que plus simples, peuvent être utilisées dans des domaines sensibles comme les décisions médicales ou juridiques. Le gouverneur a souligné la nécessité d’une régulation plus flexible, capable de s’adapter à l’évolution rapide de la technologie.

Bien que la loi SB 1047 ait été rejetée, Newsom a affirmé que la Californie continuerait à travailler sur la régulation de l’IA. Son administration a déjà signé 17 lois liées à l’IA en 2024, couvrant des sujets tels que la désinformation générée par IA et la protection des infrastructures critiques. L’objectif est de créer une législation plus ajustée aux risques réels de chaque modèle et aux contextes d’utilisation spécifiques.

Comparaison avec les régulations européennes et chinoises

La Californie n’est pas la seule à chercher à réguler l’IA. En Europe, l’AI Act adopté en 2024 offre un cadre plus large en couvrant tous les types de systèmes d’IA, des modèles basiques aux IA avancées. Cette régulation impose des standards stricts de transparence et de gestion des risques pour garantir la protection des droits fondamentaux des citoyens. À l’inverse, la Chine a une approche plus centralisée, intégrant la régulation de l’IA directement dans son cadre législatif national, avec des règles spécifiques selon les régions et les types de modèles développés.

L’impact sur l’innovation et la conformité

Le veto de la SB 1047 soulève des questions sur l’avenir de la régulation de l’IA aux États-Unis. La Californie, où se trouvent 32 des 50 plus grandes entreprises d’IA au monde, joue un rôle clé dans l’écosystème mondial de l’IA. Cependant, l’absence d’une réglementation complète pour les modèles d’IA avancés laisse un vide qui devra être comblé, que ce soit par des régulations plus flexibles ou par des directives fédérales plus globales.

D’un autre côté, les régulations européennes comme l’AI Act pourraient influencer les pratiques américaines. En effet, les entreprises qui souhaitent opérer en Europe devront se conformer aux normes strictes de l’UE, ce qui pourrait, à terme, pousser les États-Unis à adopter des standards similaires pour éviter des désaccords commerciaux.

Quel avenir pour la régulation de l’IA en Californie ?

Le rejet de la loi SB 1047 marque une pause dans la mise en place d’une régulation stricte des systèmes d’IA avancés en Californie. Néanmoins, cela ne signifie pas que l’État abandonne l’idée de réguler l’IA. Au contraire, le gouverneur Newsom a exprimé sa volonté de travailler sur des mesures plus souples et adaptées aux risques réels. Pour les entreprises, il reste crucial de suivre ces évolutions législatives afin de garantir la conformité de leurs systèmes d’IA dans un cadre réglementaire en pleine transformation.

Pourquoi la formation et la veille sur l’IA sont essentielles

L’intelligence artificielle est une technologie en constante évolution, qui bouleverse de nombreux secteurs. Comme nous l’avons vu avec les exemples de la loi SB 1047 en Californie et de l’AI Act en Europe, les réglementations suivent difficilement le rythme rapide des avancées technologiques. Cela crée un besoin critique pour les entreprises de non seulement adopter ces technologies de manière responsable, mais aussi de se tenir informées des évolutions législatives.

La formation à l’IA devient donc essentielle pour comprendre non seulement le fonctionnement des systèmes d’IA, mais aussi les risques potentiels et les cadres réglementaires qui s’y rattachent. Se former permet de mieux appréhender ces technologies et de les utiliser de manière conforme et éthique, tout en anticipant les futures exigences légales. Les entreprises qui investissent dans la montée en compétence de leurs équipes sur l’IA seront mieux préparées à naviguer dans cet environnement complexe et à éviter les sanctions.

Unow propose un catalogue de formations dédiées à l’IA pour vous accompagner dans cette transition. Nos parcours de formation sont conçus pour vous aider à maîtriser les enjeux technologiques et réglementaires, afin de garantir une utilisation responsable de l’IA au sein de vos organisations. Rester à jour sur les normes et régulations à venir est un impératif pour toute entreprise souhaitant tirer le meilleur parti de l’IA tout en respectant les nouvelles régulations.

Découvrez notre gamme de formations dédiées aux IA génératives

Tout pour comprendre les enjeux de l’IA et l’utiliser correctement au quotidien

Voir les formationsEnvie d’en voir un peu plus ?

-

Actualités

Adoption de l’IA en entreprise : comment structurer une stratégie efficace et identifier les bons cas d’usage ?

Structurer une stratégie IA efficace, choisir les bons cas d’usage, embarquer les équipes : les clés pour une adoption concrète et progressive de l’IA.

-

Actualités

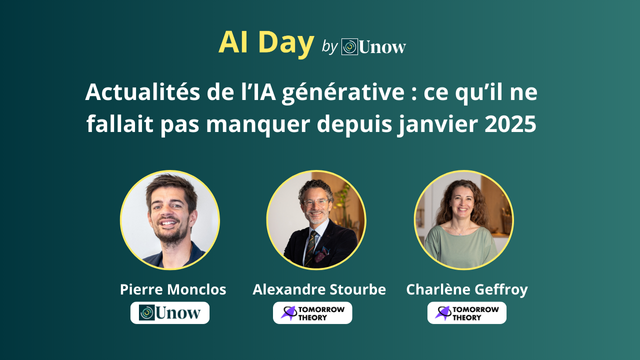

Actualités de l’IA générative : ce qu’il ne fallait pas manquer depuis janvier 2025

Compte-rendu du premier webinaire de l’AI Day organisé par Unow : une veille des innovations majeures survenues entre janvier et début avril 2025.

-

Actualités

FNE-Formation et FSE+ : ce qu’il faut savoir en 2025 pour financer vos formations

FNE et FSE+ 2025 : deux opportunités de financement à saisir pour former vos équipes sur des compétences clés.