AI Act : comprendre la nouvelle réglementation européenne sur l’intelligence artificielle

Au niveau européen, l’AI Act, adopté le 1er août 2024, est une régulation clé à surveiller.

Par Magali Mezerette – Le 3 octobre 2024

L’intelligence artificielle (IA) est en train de transformer profondément nos sociétés, nos entreprises, et nos méthodes de travail. Cette transformation s’accompagne d’une multitude de régulations à travers le monde, visant à encadrer son utilisation pour protéger les droits fondamentaux et garantir des pratiques éthiques. Lors d’un récent webinaire organisé par Unow en partenariat avec Tomorrow Theory, un état des lieux a été fait sur les différentes régulations en vigueur et à venir concernant l’IA. Voici les points clés abordés lors de cette session.

Cet article est extrait du webinaire « IA & RH : les actualités importantes de la rentrée » qui a eu lieu le 18 septembre 2024. Pour voir le replay :

Un sujet complexe et en pleine expansion

L’IA attire une attention croissante de la part des législateurs, qu’ils soient en France, en Europe ou à l’international. Les réglementations en vigueur ou en préparation touchent divers aspects de son utilisation, de la protection des données à la sécurité en passant par l’éthique. En France, le RGPD (Règlement Général sur la Protection des Données) constitue un premier cadre réglementaire majeur, tandis que des lois comme la loi des JO 2024 encadrent des usages spécifiques de l’IA, comme la reconnaissance faciale pendant les Jeux Olympiques.

Le cadre européen : l’AI Act

Au niveau européen, l’AI Act, adopté le 1er août 2024, est une régulation clé à surveiller. Cette loi vise à encadrer l’utilisation de l’IA au sein de l’Union européenne, en mettant en place des règles strictes pour protéger les droits des citoyens tout en favorisant l’innovation. L’IA Act repose sur trois grands principes :

La protection des droits fondamentaux : En ligne avec le RGPD, cette régulation vise à garantir que l’IA respecte les droits et les valeurs fondamentales de l’UE.

La promotion de l’innovation : L’objectif est de promouvoir le développement de technologies IA tout en assurant un usage éthique et sécurisé.

Un cadre juridique harmonisé : Le but est de créer une régulation cohérente à l’échelle européenne, appliquée de manière uniforme dans les États membres.

Qui est concerné par l’AI Act ?

L’AI Act concerne un large éventail d’acteurs qui interviennent dans le cycle de vie des systèmes d’intelligence artificielle. La réglementation implique toute personne morale (entreprises, associations, administrations, etc.) fournissant, distribuant ou déployant des systèmes ou des modèles d’intelligence artificielle à partir du moment où ses services sont distribués et/ou établis utilisés dans l’UE. Trois catégories principales sont identifiées dans la réglementation :

Les fournisseurs : Ce sont les créateurs ou développeurs de systèmes d’IA, comme les entreprises à l’origine de grandes IA génératives telles que ChatGPT. Ils sont responsables de garantir la conformité technique de leurs systèmes avec les exigences réglementaires.

Les distributeurs : Il s’agit des entreprises qui vendent ou fournissent des solutions d’IA à d’autres organisations. Ils doivent s’assurer que les systèmes d’IA qu’ils distribuent respectent les normes en vigueur.

Les déployants : Ce sont les organisations qui utilisent directement des systèmes d’IA dans leurs processus internes, par exemple pour l’automatisation des tâches RH, le tri de CV ou la gestion de la relation client. Les entreprises doivent être particulièrement vigilantes, car elles sont tenues de garantir la transparence, la gestion des risques, et l’éthique dans l’utilisation de ces systèmes.

En résumé, que vous soyez développeur, intégrateur ou utilisateur de l’IA, l’AI Act vous impose des obligations spécifiques pour assurer une utilisation responsable et conforme des technologies d’IA.

Une catégorisation des risques

L’un des aspects centraux de l’AI Act est la définition de quatre niveaux de risque pour l’utilisation de l’IA, allant du risque acceptable au risque inacceptable. Le niveau de risque détermine les contraintes et obligations qui s’appliquent aux systèmes d’IA concernés.

Risque inacceptable : Ce niveau concerne les IA qui utilisent des techniques subliminales pour manipuler les comportements humains, altérer leur jugement, ou causer des préjudices importants. Ces pratiques sont strictement interdites. Un exemple notable est le scandale de Cambridge Analytica, où l’exploitation de données psychographiques a été utilisée à des fins politiques pour influencer les électeurs.

Risque élevé : Les IA classées à haut risque ne sont pas interdites, mais elles doivent respecter des exigences strictes en matière de gestion des risques, de transparence, et d’évaluation. Cela inclut la nécessité de fournir des documentations techniques détaillées, d’effectuer des analyses d’impact, et d’assurer la conformité avec les réglementations européennes. Un bon exemple de ce type d’IA est celle utilisée dans les processus de recrutement automatisé, qui doit fournir des garanties sur les méthodes de sélection, les critères d’évaluation, et l’intervention humaine.

Risque limité : Ce niveau concerne des IA utilisées dans des applications où les conséquences sont moindres, comme les chatbots ou les systèmes de filtrage de courriels. Ici, la régulation repose sur un système de volontariat et de codes de conduite, encore en cours de définition.

Risque minimum : Il s’agit des IA dont l’impact est négligeable ou positif, comme les assistants virtuels simples. Peu de contraintes réglementaires s’appliquent à ce niveau.

Le risque inacceptable est divisé en 8 catégories :

1 – IA ayant recours à des techniques subliminales pour manipuler les personnes

2 – IA qui exploitent les vulnérabilités de certaines personnes pour altérer leur comportement.

3 – IA de profilages (ex: score social en Chine)

4 – IA sur sur la prédiction des infractions pénales par profilage (cas Compas aux États Unis)

5 – IA procédant à l’extraction non ciblée d’images faciales, avec pour but de créer des bases de données de reconnaissance faciale

6 – IA de système de reconnaissance des émotions sur le lieu de travail

7 – IA de profilage biométrique dans les domaines autres que le domaine répressif

8 – IA couvrant certains usages de profilage et d’identification biométrique en temps réel dans le domaine répressif.

Le cas des IA génératives et à fort impact

Les IA génératives telles que ChatGPT entrent dans une catégorie particulière en raison de leur potentiel à grande échelle et de leur influence systémique. Le SB1047, une loi californienne, est également en discussion pour encadrer l’utilisation de ces IA, particulièrement en ce qui concerne la cybersécurité. L’AI Act impose des obligations spécifiques pour ces IA à fort impact, notamment la production de documentations techniques, des essais contradictoires pour vérifier leur fonctionnement, et des mesures pour atténuer les risques systémiques qu’elles pourraient poser.

Les implications pour les entreprises

Pour les entreprises, la mise en conformité avec l’AI Act sera cruciale dans les prochains mois. Les systèmes d’IA à haut risque, utilisés notamment dans les processus RH (tri de CV, entretiens vidéo automatisés, tests prédictifs), seront particulièrement concernés. Ces systèmes devront répondre à des critères stricts de transparence, de gestion des biais, et de documentation des processus utilisés.

Les entreprises devront également s’assurer de mettre en place des évaluations régulières des risques associés à l’utilisation de l’IA et de fournir des mesures correctives si des biais ou des problèmes sont identifiés. De plus, un certificat de conformité devra être obtenu pour que ces systèmes puissent continuer à être utilisés en toute légalité.

À découvrir sur le blog : Interview – L’impact de l’IA pour les compétences métiers : de la sensibilisation à la formation

Un avenir réglementaire encore en construction

Les réglementations autour de l’IA continueront à évoluer dans les mois et années à venir. Les entreprises devront être vigilantes quant à l’évolution de ces textes et s’assurer de respecter les nouvelles obligations imposées par l’Union européenne et les régulations internationales. Bien que certaines réglementations soient déjà en place, d’autres, comme les codes de conduite ou les analyses d’impact plus détaillées, sont encore en cours de développement.

Conclusion : entre innovation et réglementation

L’IA représente un énorme potentiel d’innovation, mais elle doit être utilisée de manière responsable. La régulation, bien que complexe, vise à garantir que ces technologies servent les intérêts des citoyens et respectent leurs droits. En tant qu’entreprises, il est crucial de suivre ces évolutions de près et de se préparer à des changements réglementaires importants qui impacteront leur utilisation de l’IA, particulièrement dans les secteurs à haut risque comme les RH.

En résumé, la prudence est de mise. Une mauvaise gestion de la conformité aux nouvelles règles pourrait entraîner des sanctions, voire l’impossibilité de continuer à utiliser certains systèmes d’IA. Le chemin vers une IA éthique et conforme est encore long, mais il est indispensable pour un déploiement durable et sûr de ces technologies.

Pour respecter la réglementation et éviter les dérives dans votre entreprise, il est indispensable de cadrer les pratiques et de former vos collaborateurs. Unow propose un catalogue de formations dédiées à l’IA, conçu pour vous accompagner dans cette transition technologique en toute conformité. Grâce à nos experts et à des parcours de formation adaptés, nous vous aidons à maîtriser les enjeux de l’IA et à l’utiliser de manière éthique et sécurisée.

Découvrez notre gamme de formations dédiées aux IA génératives

Formez vos équipes dès maintenant

Voir les formationsEnvie d’en voir un peu plus ?

-

Actualités

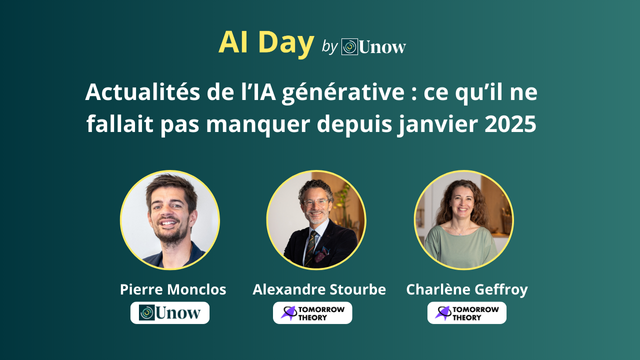

Actualités de l’IA générative : ce qu’il ne fallait pas manquer depuis janvier 2025

Compte-rendu du premier webinaire de l’AI Day organisé par Unow : une veille des innovations majeures survenues entre janvier et début avril 2025.

-

Actualités

FNE-Formation et FSE+ : ce qu’il faut savoir en 2025 pour financer vos formations

FNE et FSE+ 2025 : deux opportunités de financement à saisir pour former vos équipes sur des compétences clés.

-

Actualités

Le MOOC IA & RH revient en juin 2025 : inscrivez-vous dès maintenant

Comprendre les enjeux de l’IA dans les RH n’a jamais été aussi accessible